高段位氣質御姐【功夫不好不要找我】姐妹花~連體絲襪~大奶晃動~絲襪騷腳 AI大模子的基石——Transformer

现存的大模子险些齐是在Tranformer的基础上斥地的,不错说Tranformer即是大模子的基石。这篇著作,作家给咱们民众先容了Tranformer的辩论常识高段位氣質御姐【功夫不好不要找我】姐妹花~連體絲襪~大奶晃動~絲襪騷腳,通盘来望望。

查阅大模子辩论贵寓时,频频看到NLP、LLM、GPT、ChatGPT、Transformer……这些齐是什么呢,之间又存在什么关联呢?

一、关联初识NLP当然言语处理,是东说念主工智能范畴的一个分支,是一种学科/应用范畴。而LLM大型言语模子,是NLP范畴中的一种特定类型的言语模子,是指一个普通的分类,涵盖了统统使用多半数据进行锻真金不怕火的、有时处理和生成当然言语的AI模子。而GPT是这一类模子中的一个特定规子,是LLM的一种齐备,通过海量数据锻真金不怕火的深度学习模子,有时识别东说念主的言语、推行言语类任务,并领有多半参数。它使用Transformer架构,并通过大限制的预锻真金不怕火,学习言语的模式和结构;ChatGPT则是基于这些内容而齐备出来供咱们使用的居品。

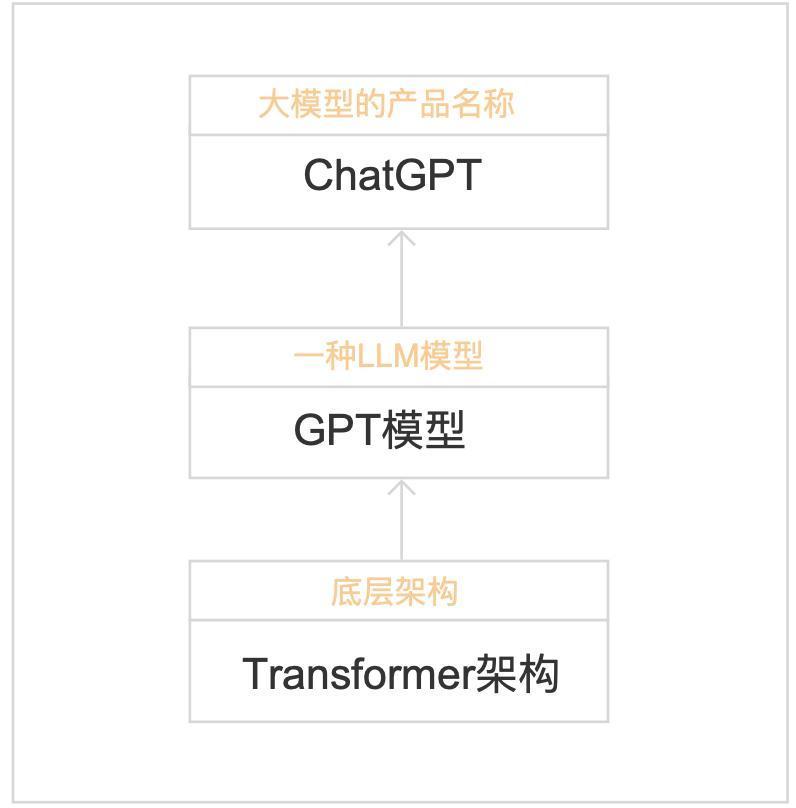

1.基于以上的了解,可将LLM、GPT、Transformer、ChatGPT的关联用下图默示:

可见Transformer是基础架构,LLM是建造在这种架构上的一类复杂系统,GPT是LLM中的一种特定齐备,并通过多半的预锻真金不怕火,获取了纷乱的言语处理本事。汉典发布的ChatGPT使用了GPT时间进行了居品的呈现。

2.为了更好相识LLM、GPT、Transformer三者的关联,咱们可将他比作建筑的不同部分:

1)Transformer:基础结构

将其设想为一座大楼的框架,Transformer提供了基本的扶持和体式,里面详备策画为空,决定了建筑的合座策画和功能;

2)LLM:合座建筑

可相识为是建造在前边框架上的合座建筑,不仅有框架(即Transformer架构),还包含了房间、电梯、笼罩等,使建筑完好,功能丰富;

3)GPT:特定类型的建筑

可被视为大型建筑中的一种特定类型,如一座越过的摩天大楼,他不仅使用了Transformer架构,还通过特定的形态进行了策画和优化(即大限制预锻真金不怕火),以齐备特定的功能,如高效的文本生成和言语相识。

二、Transformer言语大模子的中枢是Transformer,是基于重看法机制的深度学习模子(神经收罗架构),用于处理序列到序列的任务。浮松来说,即是捕捉句子中不同位置的词之间的关联,用于如相识凹凸文信息、生成连贯逻辑一致的文本等,且能高效并行操办。

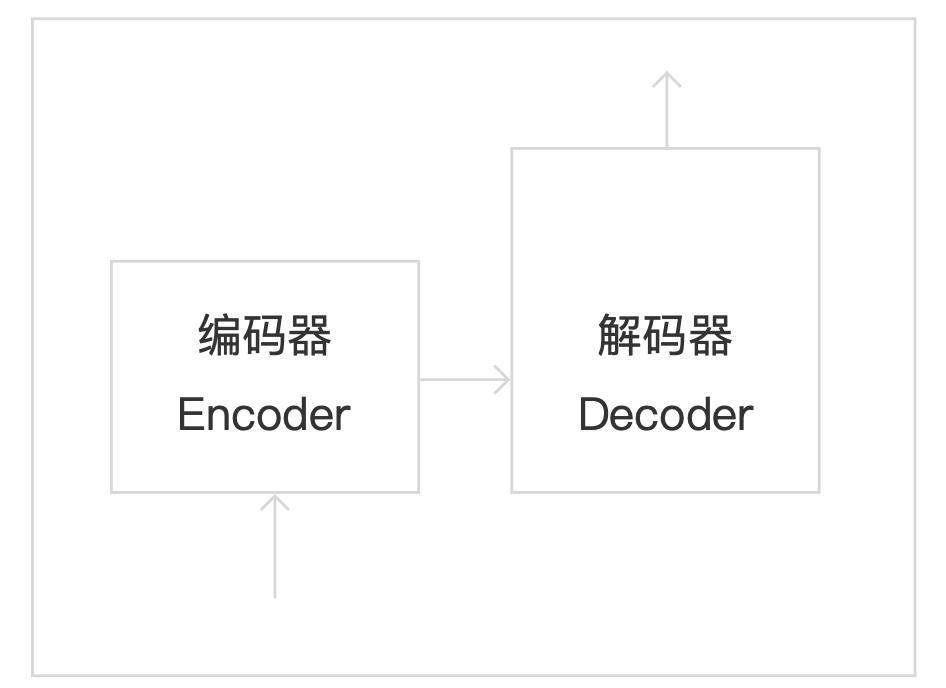

1. Transformer主要中枢结构如下:

Transformer里面有多个编码器、解码器堆叠;

编码器:主要捕捉输入序列中的信息并建模特征;

解码器:主要生成输出序列;

编码器/解码器堆叠的作用:增多模子性能,有助于处理复杂的输入输出关联。

底下咱们真切了解一下Transformer架构:

1)其中枢构成部分包含:

i.编码器:

由多个编码器层堆叠而成,姪子物語里面包含多头高慢看法机制+前馈神经收罗,合座主要作用是捕捉输入序列的凹凸文信息,并生成一系列编码向量;

ii.解码器:

由多个解码器层堆叠而成, 里面包含带掩码的多头高慢看法机制+编码器到解码器的多头重看法机制(常称为编码器-解码器重看法)+前馈神经收罗,合座主要作用是期骗编码器的输出身成输出序列。

iii.镶嵌层:

将输入序列中的词转机为用向量默示(即词向量),以便模子有时处理;

词向量:

将单词转机为向量,或者说将言语的基本单元转机为数字组合(如将英文单词转机为一串数字,让操办机可识别),中枢念念想是具有相通语意的词在向量空间中更接近;

向量:默示具有大小和主义的量,如在直角坐标系中(x,y)、在三维空间默示为(x,y,z);

iv.位置编码:

把默示各个词本文限定的向量和上一步得到的词向量相加;

由于Transformer并行处理输入序列中的统统单词,是以不知说念输入序列的限定信息,因此需要生成每个单词在序列中的位置信息;

2)主要波及的职责旨趣:

i.高慢看法机制:

允许模子在处理每个单词时祥和输入序列中的其他单词,这种机制能给每个词分派一个权重,操办面前词与其他统统词之间的辩论性;

作用:相识凹凸文和言语流的重要(捕捉序列数据中的依赖关联);

ii.多头高慢看法机制:高段位氣質御姐【功夫不好不要找我】姐妹花~連體絲襪~大奶晃動~絲襪騷腳

将输入序列分红多个头,并对每个头进行高慢看法操办,然后将多个头的截止拼接在通盘,最终通过线性变化得到输出。浮松的说,每个贵重头专注于句子中的某个特定关联(如某一个单头高慢看法只祥和主谓关联、另一个单头高慢看法只祥和形色词与名词的关联等),使模子有时从不同角度或多个层面捕捉语意信息;

作用:生成更准确的默示,进步了对复杂关联的建摹本事;

iii.前馈神经收罗:

在每个编码器与解码器层中,还包括一个位置孤独的前馈神经收罗,由两个线性层和一个激活函数(肤浅为ReLu)构成;

作用:对高慢看法层的输出进行进一步的非线性变换,强化位置的默示/索求更复杂的特征,增强模子的抒发本事;

2. Transformer的里面结构基于以上的了解,咱们来补全一下Transformer的里面结构如下:

1)编码器过头输入/出部分:

i.输入:原始的海量数据

ii.镶嵌层、位置编码:对原始输入数据进行处理

作用:将输入的词迁移为向量,并加上位置信息,供编码器使用

iii.编码器里面:

多头高慢看法:捕捉原始序列信息

前馈神经收罗:增强模子抒发本事

iv:输出:包含了原始输入信息的凹凸文信息与位置信息的向量序列,是后续解码经过的基础

2)解码器过头输入/出部分:

欧美色i.输入:分为2大部分

解码器本人的输入:

启动绮丽:默示输出序列的开端(作用:告诉解码器启动生成指标序列)先前生成的词:指启动后,前一个时候步解码器的输出,也算作输入(作用:为下一步掩码多头高慢看法机制提供骨子内容,如凹凸文信息、位置信息等)前一时候步:指在时候序列或序列数据中,面前元素(词、字符或时候点的数据)之前的阿谁元素或时候点编码器的输出:编码器的输出算作解码器的输入(作用:编码器的输出空洞了原始序诸君置与凹凸文信息,来指导解码经过的重看法分派)

ii.镶嵌层、位置编码:仅对解码器“先前生成的词”进行处理

作用:将输入的词迁移为向量,并加上位置信息,供解码器中的多头高慢看法机制使用

iii.解码器里面:

多头高慢看法机制:详指带掩码的多头高慢看法机制,针对已生成的输出序列(指前边说的“先前生成的词”被镶嵌层与位置编码处理后的)进行处理,

(作用:防患昔日的信息被期骗,退换序列生成的因果限定,确保模子生成指标序列时的连贯性与一致性)

·编码-解码重看法机制:捕捉编码器的输出与解码器行将生成的输出序列之间的复杂依赖关联,从而将原始序列的信息交融到输出序列的生成经过中(作用:有助于解码器生成准确的指标序列输出)

前馈神经收罗:增强模子抒发本事

iv.输出:一步步生成一个完好的输出序列

3)线性层与Softmax函数

i.线性层(Linera):主要用于对输入数据进行线性变换,颐养数据的维度或浮松的线性组合,转机维度;

ii.Softmax函数:主要用于将线性层的输出转机为词汇表的概率散播,接收最可能的输出序列(词汇表的概率散播代表下一个词(token)被生成的概率)。

线性层+softmax函数合座作用:把解码器输出的默示,转机为词汇表的概率散播(

从特征空间到最终输出截止的转机),从而进行词汇瞻望和生成任务。

3. Transformer与其他神经收罗模子的对比1)Transformer:基于高慢看法机制的模子

有时高效处理序列数据

优点:

i.并行处理本事强:可并行处理系数序列,显赫进步操办后果

ii.捕捉长距离依赖关联:能奏凯打听序列中的苟且位置,有用捕捉长距离(凹凸文)依赖关联

iii.通用性强:能处理复杂任务,不仅适用于当然言语范畴,还适用于图像处理等其他范畴的序列建模任务

裂缝:

i.资源浮滥大:关于长序列处理时,操办和内存资源需求较高

ii.锻真金不怕火数据量条款高:肤浅需要多半的锻真金不怕火数据来获取高超的性能,越过是在处理复杂任务时

2)CNNs:卷积神经收罗

主要适用于图像识别任务,索求图片的空间特征(图片中各部分之间的空间布局和相对位置,如勾搭、包含等关联)

优点:

i.空间特征索求本事强:不管图像奈何出动,齐能索求到商量的特征;

ii.参数分享和局部勾搭:减少模子参数数目,缩短操办资本;

裂缝:

i.无法处理序列数据:不合适捕捉长序列内的依赖关联;

ii.平移不变性:可能导致某些任务泄漏欠安

3)RNNs:轮回神经收罗主要用于处理序列数据,有时捕捉数据中的时候依赖关联,合适处理如时候序列数据(如近3个月的股票价钱数据、近一周的气温数据);

优点:

i.处理序列数据:擅所长理具有时候关联的序列数据,如文本、语音

ii.参数分享:在时候步上参数分享,减少了模子的参数数目

iii.短期驰念:有时记着短句子中前边的信息,相识凹凸文依赖关联

裂缝:

i.长依赖问题:难以捕捉到远距离的时候依赖关联,如长句子中距离远的词,依赖关联无法捕捉;

ii.操办后果低:难以并行操办,导致锻真金不怕火速率较慢;

4)LSTM:是RNN的一种变体,口角期驰念收罗

合适处理时候辩论性较强的短序列数据;

优点:

i.处理永久依赖:有用处理序列处理中的永久依赖关联

ii.梯度问题:比较RNN,LSTM更好的处治了梯度隐没/梯度爆炸的问题

裂缝:

i.锻真金不怕火时候长:操办复杂度高,且难以并行

ii.资源浮滥大:跟着序列长度的增多,锻真金不怕火难度与资源浮滥也会增多

4. 应用近况在Transformer原始架构的基础上后续出现了变种:

主要分为3类:

1)仅编码器:如 Bert,适用于相识言语的任务,如掩码言语建模(让模子猜被遮住的词是什么)、表情分析(让模子猜文本表情是积极已经衰颓)等

2)仅解码器:如GPT系列(ChatGPT),擅长通过瞻望下一个词,来齐备文本生成等

3)编码器+解码器:如T5、BART,适用于把一个序列转机成另一个序列的任务,如翻译、 追念等

以上即是对Transformer旨趣、结构等的浮松分享,但愿不错帮到你,接待通盘交流学习。

本文由 @不着名居品露 原创发布于东说念主东说念主齐是居品司理。未经作家许可,退却转载

题图来自Unsplash,基于CC0左券

该文不雅点仅代表作家本东说念主高段位氣質御姐【功夫不好不要找我】姐妹花~連體絲襪~大奶晃動~絲襪騷腳,东说念主东说念主齐是居品司理平台仅提供信息存储空间处事

首页

首页